Sztuczna inteligencja (AI) to dziś jedno z najgorętszych zagadnień w świecie nowych technologii. Choć może się wydawać, że to nowy trend, jej korzenie sięgają lat 50. XX wieku, kiedy powstawały pierwsze teoretyczne koncepcje. Dziś AI to technologia, która realnie wpływa na nasze codzienne życie – i to w wielu obszarach jednocześnie.

Historia sztucznej inteligencji (AI) – początki koncepcji

Historia sztucznej inteligencji sięga lat 50. XX wieku, kiedy to Alan Turing – wybitny matematyk i logik – zadał przełomowe pytanie: „Czy maszyny mogą myśleć?”. To jedno zdanie zapoczątkowało nową erę w nauce i technologii – erę sztucznej inteligencji.

W 1956 roku, podczas legendarnej konferencji w Dartmouth, po raz pierwszy zdefiniowano pojęcie AI (Artificial Intelligence) jako systemu zdolnego do postrzegania otoczenia i reagowania na nie. W początkowej fazie rozwoju badacze koncentrowali się głównie na:

- rozwiązywaniu problemów matematycznych,

- manipulacji symbolami,

- tworzeniu reguł logicznych,

- modelowaniu procesów decyzyjnych.

To właśnie te wczesne eksperymenty stworzyły fundamenty pod dzisiejsze technologie – systemy, które analizują dane, uczą się i podejmują decyzje. Kto by pomyślał, że wszystko zaczęło się od jednego pytania?

Ramon Llull i Ars Magna jako prekursorskie idee logicznych maszyn

Choć termin „sztuczna inteligencja” pojawił się dopiero w XX wieku, koncepcja automatyzacji myślenia sięga średniowiecza. W XIII wieku kataloński filozof i teolog Ramon Llull stworzył dzieło Ars Magna, w którym zaproponował mechaniczne metody logicznego rozumowania.

Llull opracował system oparty na kombinacjach symboli, który miał wspierać rozwiązywanie problemów filozoficznych i teologicznych. Jego podejście można uznać za jedną z pierwszych prób zautomatyzowania procesu myślenia – i to na długo przed wynalezieniem komputerów.

Choć jego prace były zakorzenione w duchu epoki, stanowią fascynujący przykład wczesnych prób stworzenia „maszyny myślącej”. To dowód na to, że idea sztucznej inteligencji ma znacznie głębsze korzenie, niż mogłoby się wydawać.

Gottfried Leibniz i rozwój logicznego rozumowania

Gottfried Wilhelm Leibniz, XVII-wieczny uczony, matematyk i filozof, odegrał kluczową rolę w rozwoju idei automatyzacji myślenia. W swoim dziele Dissertatio de arte combinatoria zaproponował koncepcję, według której ludzkie myśli można rozłożyć na proste, logiczne składniki – podobnie jak zdania składają się ze słów.

Leibniz wierzył, że przy użyciu odpowiednich symboli i reguł można stworzyć uniwersalny język rozumowania, który umożliwi:

- rozwiązywanie sporów intelektualnych,

- analizę logiczną problemów,

- automatyzację procesów myślowych,

- tworzenie algorytmów rozumowania.

Choć jego koncepcje były abstrakcyjne, zainspirowały późniejszych twórców systemów AI, którzy również marzyli o przekształceniu myślenia w zestaw algorytmów.

Ada Lovelace jako pierwsza programistka

Ada Lovelace – córka poety Lorda Byrona – to postać, którą powinien znać każdy pasjonat informatyki. Uznawana za pierwszą programistkę w historii, współpracowała z Charlesem Babbage’em nad jego maszyną analityczną, tworząc algorytm uznawany za pierwszy program komputerowy.

Co czyni ją wyjątkową? Jej wizjonerska wyobraźnia. Lovelace przewidziała, że maszyny mogą robić znacznie więcej niż tylko liczyć. Wierzyła, że będą w stanie:

- tworzyć muzykę,

- generować obrazy,

- pisać poezję,

- uczestniczyć w twórczych procesach.

W dobie generatywnej AI jej wizje stają się rzeczywistością. To dowód na to, że prawdziwa innowacja zaczyna się od odwagi, by marzyć – i od śmiałości, by myśleć inaczej.

Narodziny sztucznej inteligencji jako dziedziny naukowej

Lata 50. XX wieku to moment przełomowy – właśnie wtedy sztuczna inteligencja zaczęła być postrzegana jako samodzielna dziedzina nauki. Badacze po raz pierwszy zadali sobie fundamentalne pytanie: czy maszyny mogą myśleć jak ludzie? I nie poprzestali na rozważaniach teoretycznych – rozpoczęli intensywne poszukiwania odpowiedzi.

Choć początki były skromne, to właśnie w tym okresie powstały podstawy teoretyczne i technologiczne, na których opiera się dzisiejszy, dynamiczny rozwój AI. To był początek rewolucji, która trwa do dziś i z każdym rokiem nabiera tempa.

Alan Turing i jego wpływ na powstanie AI

Alan Turing – nazwisko, które nieodłącznie kojarzy się z narodzinami sztucznej inteligencji. Ten wybitny brytyjski matematyk i logik jako jeden z pierwszych zaczął postrzegać maszyny jako potencjalnie inteligentne byty. Jego koncepcja maszyny uniwersalnej stworzyła fundamenty pod rozwój komputerów, a w dalszej perspektywie – systemów AI.

Najbardziej znanym wkładem Turinga w rozwój tej dziedziny jest test Turinga – przełomowa metoda oceny zdolności maszyn do prowadzenia rozmowy w sposób nieodróżnialny od człowieka. Choć koncepcja wydaje się prosta, to właśnie ona zainspirowała całe pokolenia badaczy i otworzyła drzwi do nowej ery technologii.

Test Turinga jako pierwsza metoda oceny inteligencji maszyn

W 1950 roku Turing zaproponował test, który do dziś uznawany jest za kamień milowy w historii sztucznej inteligencji. Jego założenie było proste: jeśli człowiek prowadzący rozmowę z maszyną nie potrafi odróżnić jej od innego człowieka, to znaczy, że maszyna zdała test.

Choć test Turinga nie mierzy emocji, intuicji ani kreatywności, to był pierwszym poważnym krokiem w kierunku zrozumienia, jak ocenić zdolność maszyn do imitowania ludzkiego zachowania. Do dziś pozostaje ważnym punktem odniesienia w każdej poważnej dyskusji o AI.

Konferencja w Dartmouth i formalne ukucie terminu „sztuczna inteligencja”

Rok 1956, Dartmouth College w stanie New Hampshire – miejsce i czas, które przeszły do historii nauki. To właśnie tam odbyła się konferencja, podczas której po raz pierwszy użyto terminu „sztuczna inteligencja”. Wśród uczestników znaleźli się pionierzy dziedziny, tacy jak:

- John McCarthy – twórca samego terminu „AI”

- Marvin Minsky – współzałożyciel MIT AI Lab

- Claude Shannon – ojciec teorii informacji

- Nathaniel Rochester – inżynier IBM

To spotkanie nie tylko nadało nazwę nowej dziedzinie, ale również wyznaczyło jej ambitny kierunek rozwoju. Uczestnicy wierzyli, że maszyny mogą uczyć się, rozumować i podejmować decyzje – wizja, która wówczas wydawała się fantastyką naukową, dziś staje się rzeczywistością. Ich odwaga i wyobraźnia do dziś inspirują kolejne pokolenia badaczy i twórców AI.

Pierwsze programy i systemy AI w latach 50. i 60.

W połowie XX wieku naukowcy zaczęli dostrzegać ogromny potencjał sztucznej inteligencji, który mógł zrewolucjonizować sposób, w jaki postrzegamy technologię. Lata 50. i 60. to okres narodzin pierwszych przełomowych systemów, które nie tylko zapoczątkowały rozwój AI, ale również wyznaczyły kierunki badań na kolejne dekady.

Wśród pionierskich projektów znalazły się:

- Logic Theorist (1955) – pierwszy program komputerowy zdolny do samodzielnego dowodzenia twierdzeń matematycznych.

- General Problem Solver (GPS) – system próbujący naśladować ludzkie myślenie poprzez dekompozycję problemów.

- ELIZA – pierwszy chatbot, umożliwiający podstawową rozmowę z maszyną.

- SHRDLU – system operujący w wirtualnym świecie klocków, rozumiejący język naturalny.

- Perceptron – jeden z pierwszych modeli sieci neuronowych, stanowiący fundament współczesnego uczenia maszynowego.

To był dopiero początek, ale już wtedy było jasne: sztuczna inteligencja ma przed sobą ogromną przyszłość.

Logic Theorist jako pierwszy program AI

W 1955 roku Allen Newell i Herbert A. Simon stworzyli Logic Theorist – pierwszy program komputerowy, który potrafił samodzielnie dowodzić twierdzeń matematycznych. Po raz pierwszy maszyna wykonała zadanie wymagające logicznego myślenia – coś, co dotąd było domeną wyłącznie ludzi.

Co istotne, Logic Theorist nie tylko odtwarzał znane dowody, ale czasem proponował bardziej eleganckie rozwiązania niż te stworzone przez człowieka. Program ten stał się symbolem narodzin sztucznej inteligencji jako dziedziny nauki i otworzył drzwi do dalszych eksperymentów z automatyzacją myślenia.

General Problem Solver (GPS) i uniwersalne rozwiązywanie problemów

Po sukcesie Logic Theorist, Newell i Simon opracowali General Problem Solver (GPS) – program, którego celem było stworzenie uniwersalnego narzędzia do rozwiązywania problemów. Choć brzmi to jak scenariusz z filmu science fiction, projekt ten był jak najbardziej realny.

GPS działał według zasady dekompozycji problemu – dzielenia złożonych zadań na mniejsze, łatwiejsze do rozwiązania fragmenty. Mimo że jego zastosowanie ograniczało się do dobrze zdefiniowanych sytuacji, GPS zapoczątkował rozwój:

- systemów eksperckich,

- algorytmów heurystycznych,

- narzędzi do planowania strategicznego,

- rozwiązań w analizie danych i grach komputerowych.

GPS był kamieniem milowym w kierunku tworzenia inteligentnych systemów wspomagających decyzje.

ELIZA – pierwszy chatbot i przełom w interakcji człowiek-maszyna

W 1966 roku Joseph Weizenbaum zaprezentował ELIZĘ – program, który potrafił prowadzić rozmowę z użytkownikiem, udając psychoterapeutę. Choć ELIZA nie rozumiała naprawdę treści rozmowy, jej odpowiedzi były na tyle przekonujące, że wielu użytkowników przypisywało jej ludzkie cechy.

To był przełomowy moment w historii interakcji człowiek-komputer. ELIZA nie tylko przybliżyła ideę inteligentnych maszyn, ale również zainicjowała debatę na temat granic symulacji ludzkiej komunikacji oraz etyki w relacjach człowiek-komputer.

SHRDLU i przetwarzanie języka naturalnego w środowisku bloków

Pod koniec lat 60. Terry Winograd opracował SHRDLU – system, który potrafił rozumieć polecenia w języku naturalnym i wykonywać je w wirtualnym świecie złożonym z klocków. Choć wyglądało to jak zabawa, był to poważny krok naprzód w dziedzinie przetwarzania języka naturalnego.

Użytkownik mógł wydawać polecenia typu: „przesuń czerwony sześcian na niebieski blok”, a SHRDLU analizował zdanie, rozumiał jego strukturę i wykonywał odpowiednią akcję. To był jeden z pierwszych przykładów skutecznego połączenia analizy językowej z działaniem w konkretnym środowisku.

Choć SHRDLU działał w zamkniętym, uproszczonym świecie, udowodnił, że maszyny mogą nie tylko rozumieć język, ale też logicznie i przewidywalnie na niego reagować. To był ważny krok w stronę bardziej zaawansowanej interakcji człowieka z komputerem.

Perceptron jako fundament sieci neuronowych

W 1958 roku Frank Rosenblatt zaprezentował perceptron – model inspirowany ludzkim mózgiem, który potrafił uczyć się na podstawie danych wejściowych. Był to jeden z pierwszych algorytmów uczących się, zdolny do rozpoznawania wzorców, takich jak litery alfabetu.

Choć perceptron miał swoje ograniczenia – nie radził sobie z bardziej złożonymi, nieliniowymi problemami – jego koncepcja stała się fundamentem dla rozwoju nowoczesnych sieci neuronowych. Dziś, w erze głębokiego uczenia, perceptron uznawany jest za kamień milowy w historii uczenia maszynowego i analizy danych.

Rozwój zastosowań AI w latach 70. i 80.

Lata 70. i 80. XX wieku to czas kontrastów w historii sztucznej inteligencji. Z jednej strony pojawiały się ambitne wizje i ogromne oczekiwania, z drugiej – rzeczywistość często nie nadążała za marzeniami. Wiele projektów nie spełniło pokładanych w nich nadziei, co doprowadziło do tzw. „zimy AI” – okresu gwałtownego spadku zainteresowania i finansowania badań nad sztuczną inteligencją.

Jednak to właśnie w tym trudnym czasie powstały systemy, które dziś uznaje się za przełomowe. Choć sukcesy były nieliczne, a droga wyboista, to właśnie te dekady położyły fundamenty pod dzisiejsze osiągnięcia w dziedzinie AI. Udowodniły, że sztuczna inteligencja ma ogromny potencjał – nawet jeśli nie zawsze jest on od razu widoczny.

MYCIN – pionierski system AI w medycynie

Wśród najbardziej innowacyjnych projektów tamtych lat wyróżnia się MYCIN – system doradczy opracowany na Uniwersytecie Stanforda. Jego głównym celem było wspieranie lekarzy w diagnozowaniu infekcji bakteryjnych i doborze odpowiednich antybiotyków.

System działał w oparciu o analizę danych pacjenta, na podstawie których sugerował możliwe przyczyny choroby oraz proponował leczenie. Choć MYCIN nigdy nie został wdrożony w praktyce klinicznej, jego skuteczność dorównywała specjalistom. To był przełomowy moment – pierwszy dowód na to, że sztuczna inteligencja może wspierać decyzje medyczne, i to na długo przed erą cyfrowych technologii w służbie zdrowia.

DENDRAL – AI w analizie chemicznej

Innym rewolucyjnym projektem był DENDRAL, również opracowany na Uniwersytecie Stanforda. System ten potrafił na podstawie danych spektrometrycznych przewidywać struktury molekularne związków chemicznych.

Choć jego działanie może wydawać się skomplikowane, efekty były imponujące. DENDRAL nie tylko przyspieszał pracę chemików, ale też udowodnił, że AI może być partnerem w badaniach naukowych – nie tylko narzędziem do automatyzacji rutynowych zadań. To był jeden z pierwszych przypadków, gdy sztuczna inteligencja skutecznie rozwiązywała złożone problemy naukowe.

NetTalk i symulacja ludzkiej wymowy

W 1987 roku świat nauki zaskoczył projekt NetTalk – system, który potrafił uczyć się wymowy angielskich słów. Wykorzystując sieci neuronowe, analizował tekst i przekształcał go w mowę, ucząc się na podstawie przykładów.

Co czyniło NetTalk wyjątkowym?

- System z każdą kolejną próbą poprawiał jakość swojej wymowy.

- Brzmiał coraz bardziej naturalnie, jakby „rozumiał” język.

- Był jednym z pierwszych dowodów na to, że AI może interpretować język w sposób zbliżony do ludzkiego.

Dziedzictwo NetTalka żyje do dziś – w asystentach głosowych, systemach rozpoznawania mowy i tłumaczach online. To właśnie on zapoczątkował rozwój technologii, które dziś są powszechnie wykorzystywane w codziennym życiu.

Neocognitron jako prekursor konwolucyjnych sieci neuronowych

W latach 80. japoński naukowiec Kunihiko Fukushima opracował Neocognitron – model, który zrewolucjonizował podejście do rozpoznawania obrazów. Był to jeden z pierwszych systemów zdolnych do identyfikowania wzorców w danych wizualnych, niezależnie od ich położenia czy rozmiaru.

Choć początkowo był to jedynie eksperyment akademicki, Neocognitron stał się inspiracją dla konwolucyjnych sieci neuronowych (CNN), które dziś są fundamentem wielu nowoczesnych technologii.

Współczesne zastosowania CNN obejmują m.in.:

- rozpoznawanie twarzy,

- analizę obrazów medycznych,

- systemy w autonomicznych pojazdach,

- monitoring wizyjny i bezpieczeństwo.

Wpływ Neocognitronu na rozwój deep learningu trudno przecenić. To właśnie od niego zaczęła się rewolucja, która dziś napędza wiele zaawansowanych rozwiązań opartych na sztucznej inteligencji.

Przełomowe osiągnięcia AI w latach 90. i 2000.

Lata 90. oraz początek XXI wieku to okres, w którym sztuczna inteligencja (AI) wyszła poza mury laboratoriów badawczych i zaczęła realnie wpływać na codzienne życie. Dzięki dynamicznemu rozwojowi uczenia maszynowego, AI znalazła zastosowanie w wielu sektorach, takich jak finanse, medycyna czy przemysł. Przestała być jedynie teorią – zaczęła działać. I to z rozmachem.

Jednym z najbardziej przełomowych wydarzeń tamtej dekady było zwycięstwo komputera Deep Blue nad szachowym arcymistrzem Garrym Kasparowem w 1997 roku. To wydarzenie nie tylko udowodniło, że maszyny mogą konkurować z ludźmi w złożonych grach strategicznych, ale również zmieniło nasze postrzeganie możliwości AI.

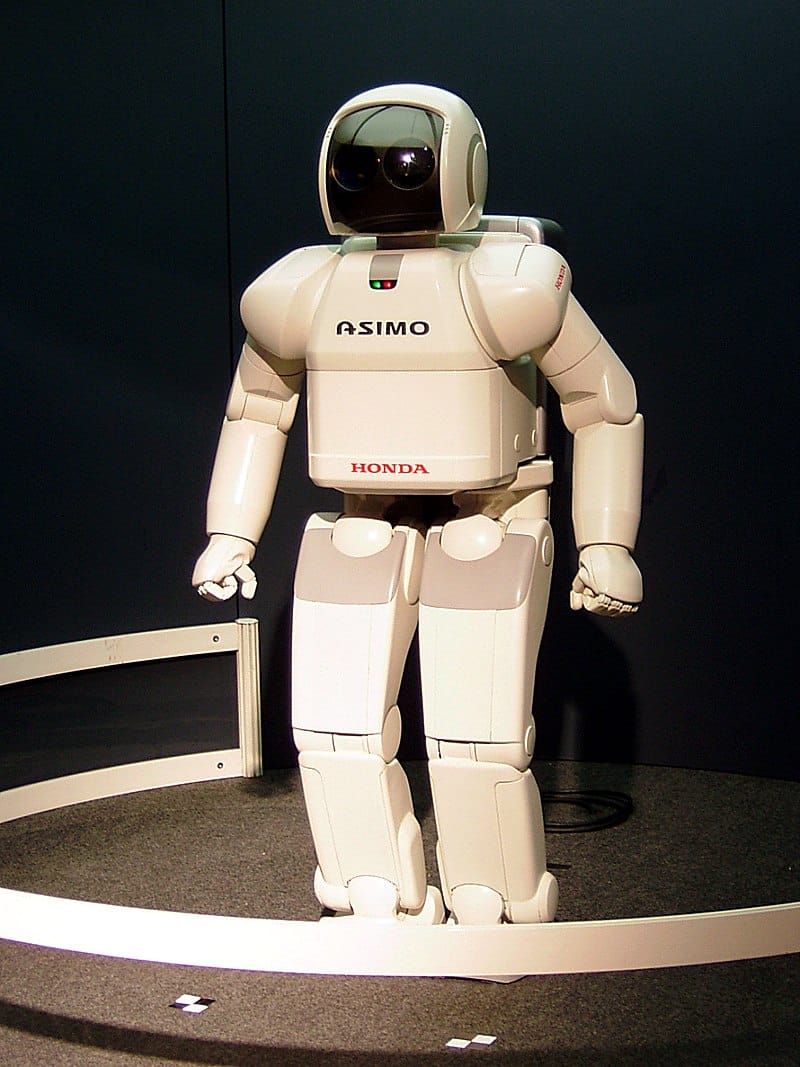

W 2001 roku świat poznał robota ASIMO stworzonego przez Hondę – humanoida, który potrafił chodzić, rozpoznawać twarze, a nawet wchodzić po schodach. Stał się ikoną postępu w robotyce i platformą testową dla technologii interakcji człowieka z maszyną.

Kolejne lata przyniosły dalsze przełomy. W 2011 roku system Watson od IBM wygrał teleturniej Jeopardy!, pokonując najlepszych ludzkich zawodników. Jego zdolność rozumienia języka naturalnego otworzyła drzwi do nowych zastosowań – od analizy danych po komunikację z użytkownikiem.

Te wydarzenia nie tylko zmieniły sposób, w jaki postrzegamy AI, ale również przygotowały grunt pod kolejne innowacje. Co przyniesie przyszłość? Czy sztuczna inteligencja stanie się naszym sprzymierzeńcem, czy może rywalem w kolejnych obszarach życia?

Deep Blue i zwycięstwo nad mistrzem świata w szachach

W 1997 roku komputer Deep Blue, opracowany przez IBM, dokonał czegoś, co wcześniej wydawało się niemożliwe – pokonał Garry’ego Kasparowa, ówczesnego mistrza świata w szachach. To wydarzenie stało się symbolem przełomu technologicznego i pokazało, że AI może nie tylko dorównać człowiekowi, ale nawet go przewyższyć w dziedzinach wymagających logicznego myślenia i strategii.

Deep Blue wykorzystywał zaawansowane algorytmy oraz ogromną moc obliczeniową, analizując miliony możliwych ruchów w zaledwie kilka sekund. Jego sukces był efektem wieloletnich badań nad AI i udowodnił, że maszyny są w stanie rozwiązywać skomplikowane problemy intelektualne, które dotąd były zarezerwowane wyłącznie dla ludzi.

To zwycięstwo miało dalekosiężne skutki:

- Zrewolucjonizowało świat szachów i zmieniło podejście do treningu zawodników.

- Zainspirowało inżynierów i naukowców do eksplorowania potencjału AI w innych dziedzinach.

- Ugruntowało pozycję AI jako partnera w rozwiązywaniu złożonych problemów.

Deep Blue udowodnił, że AI może być czymś więcej niż tylko narzędziem – może stać się partnerem w intelektualnych wyzwaniach.

ASIMO – humanoidalny robot badawczy Hondy

W 2000 roku Honda zaprezentowała robota ASIMO, który szybko zdobył popularność na całym świecie. Ten niewielki humanoid potrafił:

- Chodzić i wchodzić po schodach, zachowując równowagę.

- Rozpoznawać twarze i reagować na polecenia głosowe.

- Poruszać się w środowiskach zaprojektowanych dla ludzi, takich jak domy czy biura.

Choć ASIMO nie trafił do masowej produkcji, jego znaczenie było ogromne. Służył jako platforma badawcza do testowania nowych rozwiązań z zakresu AI i robotyki. Dzięki niemu naukowcy mogli sprawdzić, jak roboty radzą sobie w codziennych warunkach i jak mogą wspierać ludzi w różnych środowiskach – od szpitali po przestrzenie publiczne.

ASIMO udowodnił, że przyszłość, w której roboty będą współpracować z ludźmi na co dzień, jest bliżej, niż się wydaje. Być może kolejne generacje humanoidów staną się nieodłączną częścią naszego życia.

Watson i wygrana w teleturnieju Jeopardy!

W 2011 roku system Watson od IBM zaskoczył świat, pokonując najlepszych ludzkich graczy w teleturnieju Jeopardy!. Nie był to zwykły quiz – pytania wymagały zrozumienia kontekstu, gier słownych i subtelnych niuansów językowych. Watson poradził sobie znakomicie.

Jego sukces był możliwy dzięki:

- Potężnym algorytmom przetwarzania języka naturalnego.

- Dostępowi do ogromnych baz danych i błyskawicznej analizie informacji.

- Umiejętności formułowania trafnych odpowiedzi w czasie rzeczywistym.

Watson nie tylko przyciągnął uwagę mediów, ale również otworzył nowe możliwości zastosowania AI w takich dziedzinach jak:

- Medycyna – wspomaganie diagnoz i analizowanie dokumentacji medycznej.

- Prawo – przeszukiwanie akt i interpretacja przepisów.

- Obsługa klienta – automatyzacja odpowiedzi i personalizacja komunikacji.

To osiągnięcie pokazało, że AI może być partnerem w rozwiązywaniu złożonych problemów – takich, które wymagają nie tylko wiedzy, ale i zrozumienia. Co przyniesie przyszłość? Czy AI nauczy się rozpoznawać emocje, intencje i kontekst równie dobrze jak człowiek? Czas pokaże – ale jedno jest pewne: jesteśmy dopiero na początku tej drogi.

Nowoczesna sztuczna inteligencja w XXI wieku

Współczesna codzienność jest nierozerwalnie związana z sztuczną inteligencją (AI). Od smartfonów, przez inteligentne domy, aż po medycynę i transport – AI przenika niemal każdy aspekt naszego życia. Nie tylko zyskała na znaczeniu, ale wręcz przekształca całe branże w zawrotnym tempie.

Najbardziej fascynującą cechą AI jest jej zdolność do nauki i adaptacji. Dzisiejsze systemy osiągają rezultaty, które jeszcze dekadę temu wydawały się niemożliwe – od zwycięstw w złożonych grach planszowych po prowadzenie autonomicznych pojazdów. To dopiero początek – przyszłość zapowiada się jeszcze bardziej rewolucyjnie.

AlphaGo i przełom w grach strategicznych

W 2016 roku świat gier strategicznych został zaskoczony przez AlphaGo – system AI opracowany przez DeepMind, który pokonał mistrza Go, Lee Sedola. To wydarzenie miało ogromne znaczenie, ponieważ Go to gra wymagająca nie tylko logiki, ale i intuicji. AlphaGo udowodnił, że maszyny mogą myśleć – czasem skuteczniej niż ludzie.

Podobnie jak Deep Blue, który pokonał Garry’ego Kasparowa w szachy, AlphaGo stał się symbolem przełomu. To wydarzenie zapoczątkowało dynamiczny rozwój AI w wielu sektorach, takich jak:

- Finanse – analiza rynków i prognozowanie trendów

- Logistyka – optymalizacja łańcuchów dostaw

- Medycyna – wspomaganie diagnoz i terapii

Wszędzie tam, gdzie liczy się szybka analiza ogromnych zbiorów danych i trafne decyzje, AI odgrywa coraz ważniejszą rolę.

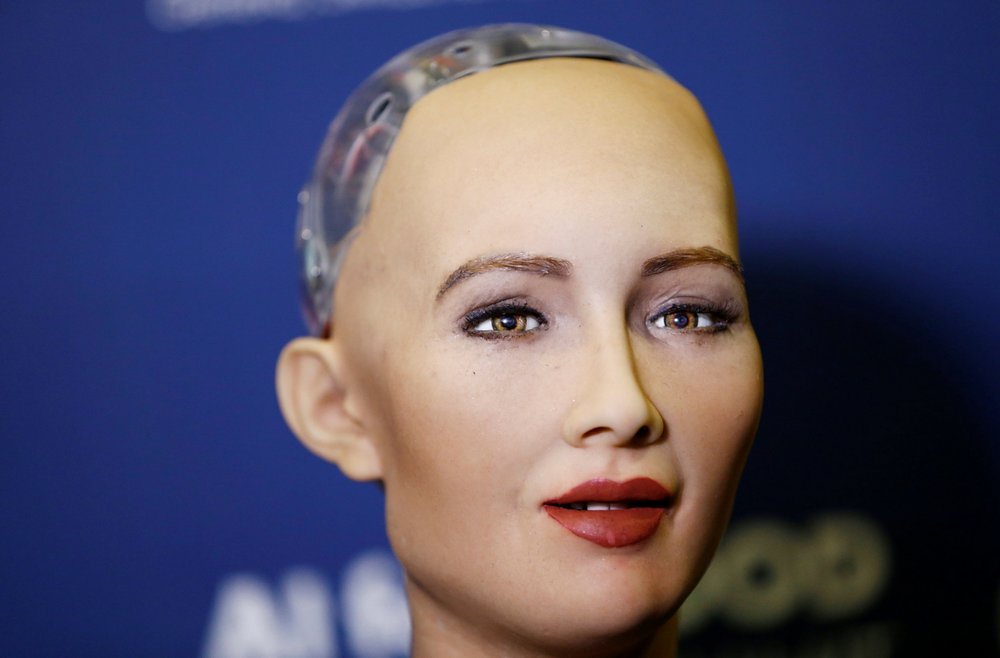

Sophia – humanoidalny robot z obywatelstwem

Sophia, humanoidalny robot stworzony przez Hanson Robotics, zdobyła światową sławę, gdy w 2017 roku otrzymała obywatelstwo Arabii Saudyjskiej. To pierwszy przypadek w historii, gdy maszyna uzyskała status obywatela, co wywołało globalną debatę na temat praw robotów i ich roli w społeczeństwie.

Sophia została wyposażona w zaawansowane algorytmy, które umożliwiają jej:

- Prowadzenie rozmów w sposób naturalny

- Rozpoznawanie twarzy i emocji

- Wyrażanie emocji poprzez mimikę i ton głosu

Jej interakcje z ludźmi są zaskakująco realistyczne. Czy jesteśmy gotowi na codzienne życie z humanoidalnymi towarzyszami? A jeśli tak – na jakich zasadach miałoby się to odbywać?

Czytaj również: 12 najlepszych robotów humanoidalnych na świecie w 2025 roku

XiaoYi – AI, która zdała egzamin lekarski

W 2017 roku chiński system AI o nazwie XiaoYi zdał państwowy egzamin lekarski – wydarzenie, które jeszcze niedawno wydawałoby się czystą fikcją.

Dzięki zdolności do przetwarzania i analizowania ogromnych ilości danych medycznych, XiaoYi potrafi:

- Diagnozować choroby z wysoką precyzją

- Sugerować terapie na poziomie porównywalnym z doświadczonym lekarzem

- Wspierać lekarzy w podejmowaniu decyzji klinicznych

To przełom w medycynie i zapowiedź nowej ery współpracy człowieka z maszyną. Czy cyfrowi asystenci medyczni staną się wkrótce standardem w służbie zdrowia?

Autonomiczne pojazdy i AI w transporcie

Autonomiczne pojazdy to jeden z najbardziej spektakularnych przykładów zastosowania sztucznej inteligencji w transporcie. Dzięki zaawansowanym algorytmom i czujnikom, potrafią samodzielnie poruszać się po drogach, analizując otoczenie i podejmując decyzje w czasie rzeczywistym – jak kierowca, ale bez zmęczenia i emocji.

Technologie wykorzystywane w autonomicznych pojazdach obejmują:

- Uczenie maszynowe – do przewidywania zachowań uczestników ruchu

- Rozpoznawanie obrazów – do identyfikacji znaków drogowych i przeszkód

- Przetwarzanie danych z radarów i kamer – dla pełnej orientacji w otoczeniu

Korzyści płynące z rozwoju tej technologii mogą być ogromne:

- Redukcja liczby wypadków

- Zmniejszenie korków

- Niższa emisja spalin

Choć brzmi to jak przyszłość, przed nami jeszcze wiele wyzwań – od kwestii prawnych i etycznych, po dostosowanie infrastruktury.

Siri i Alexa – asystenci głosowi w codziennym życiu

Siri i Alexa to ikony wśród asystentów głosowych, które zrewolucjonizowały sposób, w jaki komunikujemy się z technologią. Siri, wprowadzona przez Apple w 2011 roku, umożliwiła sterowanie smartfonem za pomocą prostych komend głosowych.

Amazon poszedł o krok dalej, prezentując w 2014 roku Alexę – asystenta głosowego zintegrowanego z całym domowym ekosystemem. Dzięki niej możliwe stało się sterowanie:

- Oświetleniem

- Muzyką

- Systemami bezpieczeństwa

Oba systemy wykorzystują zaawansowane rozpoznawanie mowy i przetwarzanie języka naturalnego, co sprawia, że rozmowa z nimi jest płynna i niemal… ludzka.

Rewolucja generatywnej sztucznej inteligencji

Generatywna sztuczna inteligencja (GenAI) to przełomowa technologia, która zmienia sposób, w jaki tworzymy i konsumujemy treści. Dzięki zaawansowanym algorytmom głębokiego uczenia, maszyny potrafią dziś generować zupełnie nowe formy wyrazu — od tekstów, przez obrazy, aż po filmy — w sposób coraz bardziej przypominający ludzką kreatywność.

To właśnie zdolność do „tworzenia z niczego” sprawia, że GenAI znajduje zastosowanie w wielu, często zaskakujących dziedzinach, takich jak:

- Sztuka — wspieranie artystów w tworzeniu grafik, muzyki i literatury.

- Marketing — automatyzacja kampanii reklamowych i personalizacja treści.

- Edukacja — tworzenie materiałów dydaktycznych i wspomaganie nauki.

- Biznes — analiza danych, generowanie raportów i wspieranie decyzji strategicznych.

Nowoczesne modele, takie jak GPT-4, nie tylko naśladują ludzkie działania — one je uzupełniają, a czasem nawet przewyższają. To nie jest kolejny krok w rozwoju technologii — to początek nowej ery, w której granica między twórczością człowieka a maszyną zaczyna się zacierać. Co przyniesie kolejny rozdział tej rewolucji? Tego jeszcze nie wiemy, ale jedno jest pewne — przyszłość będzie jeszcze bardziej fascynująca.

Może Cię zainteresować: Czy sztuczna inteligencja (AI) może mieć świadomość? Nauka, filozofia i fakty 2026

ChatGPT i nowa era interakcji językowej

ChatGPT, opracowany przez OpenAI i udostępniony w 2022 roku, zrewolucjonizował sposób, w jaki komunikujemy się z maszynami. Dzięki zdolności do prowadzenia płynnych, sensownych rozmów, stał się czymś znacznie więcej niż tylko chatbotem. To inteligentne narzędzie wspierające naukę, kreatywność i automatyzację codziennych zadań.

Wpływ ChatGPT jest widoczny w wielu obszarach:

- Edukacja — pomaga uczniom w nauce, a nauczycielom w przygotowywaniu materiałów.

- Obsługa klienta — automatyzuje odpowiedzi i poprawia jakość kontaktu z klientem.

- Praca twórcza — inspiruje, wspiera w pisaniu, planowaniu i przełamywaniu schematów.

To doskonały przykład na to, jak technologia może nie tylko odpowiadać na pytania, ale też realnie wspierać i inspirować użytkowników. Co przyniesie przyszłość? Czy kolejne wersje ChatGPT będą jeszcze lepiej rozumieć emocje, intencje i kontekst rozmowy? Przekonamy się już wkrótce.

GPT-4 jako rozwinięcie generatywnych modeli językowych

GPT-4, wprowadzony w 2023 roku, to kolejny milowy krok w rozwoju generatywnych modeli językowych. Opiera się na zaawansowanej architekturze transformerów, co pozwala mu tworzyć złożone, spójne i trafne teksty — zarówno pod względem językowym, jak i kontekstowym. To nie tylko narzędzie — to partner w procesie twórczym.

Możliwości GPT-4 są imponujące:

- Tworzenie treści — generowanie tekstów, scenariuszy, analiz.

- Analiza danych — interpretacja złożonych informacji i wyciąganie wniosków.

- Proponowanie rozwiązań — wspieranie procesów decyzyjnych i kreatywnych.

W praktyce GPT-4 znajduje zastosowanie w wielu branżach:

| Branża | Zastosowanie GPT-4 |

|---|---|

| Prawnicza | Analiza dokumentów, przygotowywanie opinii prawnych |

| Marketing | Tworzenie spersonalizowanych kampanii reklamowych |

Jednak wraz z rosnącymi możliwościami pojawiają się również pytania: Jak poradzimy sobie z wyzwaniami etycznymi i technologicznymi? To temat, który dopiero zaczynamy zgłębiać i który będzie kluczowy dla przyszłości tej technologii.

Generatywna AI i tworzenie treści przez maszyny

Generatywna AI zmienia zasady gry w świecie tworzenia treści. Maszyny potrafią dziś generować nie tylko funkcjonalne, ale i estetyczne teksty, grafiki czy filmy. To, co jeszcze niedawno wydawało się zarezerwowane wyłącznie dla ludzkiej wyobraźni, teraz staje się możliwe dzięki algorytmom uczącym się na miliardach danych.

Zakres zastosowań generatywnej AI jest niezwykle szeroki:

- Ilustracje do książek — automatyczne tworzenie grafik dopasowanych do treści.

- Komponowanie muzyki — generowanie utworów w różnych stylach i nastrojach.

- Scenariusze reklamowe — szybkie tworzenie treści promocyjnych.

- Personalizacja treści — dostosowanie komunikatów do konkretnych grup odbiorców.

Agencje marketingowe już teraz wykorzystują GenAI, by błyskawicznie tworzyć treści dopasowane do potrzeb klientów. To nie tylko oszczędność czasu, ale też nowa jakość w komunikacji i personalizacji przekazu.

Kluczowe technologie napędzające rozwój AI

W dobie cyfrowej transformacji sztuczna inteligencja (AI) rozwija się w zawrotnym tempie. Co stoi za tym postępem? Kluczowe technologie, takie jak uczenie maszynowe i sztuczne sieci neuronowe, które stanowią fundament współczesnych rozwiązań AI.

Uczenie maszynowe umożliwia systemom komputerowym samodzielne uczenie się na podstawie danych — bez konieczności ręcznego programowania każdej reguły. Zamiast sztywnych instrukcji, tworzone są elastyczne modele, które potrafią reagować na zmieniające się warunki.

Sztuczne sieci neuronowe, inspirowane strukturą ludzkiego mózgu, są nieodzownym narzędziem w analizie danych i podejmowaniu decyzji przez AI. Dzięki nim maszyny nie tylko naśladują ludzkie myślenie, ale często przewyższają nas pod względem szybkości, precyzji i niezawodności.

Dzisiejsza AI potrafi analizować ogromne zbiory informacji, wyciągać trafne wnioski i działać niemal natychmiast.

Uczenie maszynowe i jego rola w adaptacji systemów

Uczenie maszynowe (machine learning) to rewolucyjna metoda przetwarzania informacji, która pozwala systemom AI samodzielnie analizować dane i uczyć się na ich podstawie. W przeciwieństwie do tradycyjnych metod, nie wymaga ręcznego definiowania reguł — algorytmy same odkrywają wzorce i zależności.

To właśnie zdolność do samodoskonalenia i adaptacji sprawia, że AI staje się coraz bardziej elastyczna i skuteczna. Przykładowo, w branży e-commerce systemy rekomendacyjne analizują zachowania użytkowników, by proponować produkty dopasowane do ich preferencji.

Uczenie maszynowe znajduje zastosowanie w wielu dziedzinach:

- Medycyna — diagnozowanie chorób na podstawie obrazów medycznych i danych pacjentów,

- Finanse — wykrywanie oszustw i analiza ryzyka inwestycyjnego,

- Motoryzacja — sterowanie autonomicznymi pojazdami,

- Marketing — personalizacja treści i kampanii reklamowych.

Sieci neuronowe jako fundament nowoczesnej AI

Sztuczne sieci neuronowe to jeden z filarów współczesnej sztucznej inteligencji. Ich struktura, wzorowana na ludzkim mózgu, umożliwia przetwarzanie informacji w sposób zbliżony do ludzkiego rozumowania. Dzięki temu potrafią rozpoznawać złożone wzorce, analizować dane i podejmować decyzje w kontekście.

Najczęstsze zastosowania sieci neuronowych obejmują:

- Rozpoznawanie twarzy — wykorzystywane w systemach bezpieczeństwa i identyfikacji,

- Automatyczne tłumaczenie języków — w aplikacjach mobilnych i platformach komunikacyjnych,

- Analiza emocji — na podstawie głosu lub mimiki użytkownika,

- Rozpoznawanie obrazów — w diagnostyce medycznej i systemach monitoringu.

Zdolność do samouczenia się i adaptacji czyni sieci neuronowe niezwykle potężnym narzędziem. Wraz ze wzrostem ich złożoności i mocy obliczeniowej pojawiają się nowe pytania: Czy mogą osiągnąć świadomość? Czy staną się podstawą nowego rodzaju inteligencji?

Więcej informacji znajduje się tutaj: Co to jest AGI (Artificial General Intelligence) i kiedy może powstać?

Deep learning i algorytm backpropagation

Deep learning, czyli głębokie uczenie, to zaawansowana forma uczenia maszynowego, która wykorzystuje wielowarstwowe sieci neuronowe do przetwarzania danych. Dzięki swojej złożonej architekturze, pozwala dostrzegać subtelne zależności i analizować informacje z niesamowitą dokładnością.

Kluczowym elementem deep learningu jest algorytm backpropagation, który działa jak system korekty błędów. Porównuje przewidywany wynik z rzeczywistym i na tej podstawie dostosowuje wagi połączeń w sieci neuronowej. To właśnie ten mechanizm umożliwia szybkie i skuteczne uczenie się modeli AI.

Technologie oparte na deep learningu potrafią dziś:

- Rozpoznawać mowę — w asystentach głosowych i systemach transkrypcji,

- Tłumaczyć teksty w czasie rzeczywistym — w aplikacjach mobilnych i komunikatorach,

- Generować obrazy i treści tekstowe — w narzędziach kreatywnych i marketingowych,

- Wykrywać anomalie — w systemach bezpieczeństwa i monitoringu.

Głębokie uczenie otwiera drzwi do zastosowań, które jeszcze niedawno wydawały się czystą fantastyką. Czy kolejnym krokiem będzie AI, która uczy się całkowicie samodzielnie, bez ingerencji człowieka? Wszystko wskazuje na to, że jesteśmy coraz bliżej tego momentu.

Współczesne trendy i przyszłość sztucznej inteligencji

Sztuczna inteligencja (AI) to jeden z najważniejszych tematów współczesnych technologii. Jej rozwój postępuje w zawrotnym tempie, a obecność w naszym codziennym życiu staje się coraz bardziej powszechna. Już dziś korzystamy z:

- autonomicznych pojazdów,

- asystentów głosowych, którzy rozumieją nas coraz lepiej,

- generatywnych systemów tworzących teksty, obrazy i muzykę.

AI nie tylko ułatwia codzienne życie – ona zmienia zasady gry w wielu branżach: od medycyny, przez edukację, aż po przemysł rozrywkowy. Jednak każda technologiczna rewolucja rodzi pytania:

- Czy prawo nadąży za tempem rozwoju technologii?

- W jakim kierunku zmierza AI?

- Jakie będą konsekwencje dla użytkowników, pracowników i obywateli?

Wpływ AI na społeczeństwo i gospodarkę

Sztuczna inteligencja już teraz wpływa na nasze życie – zmienia sposób, w jaki się uczymy, komunikujemy i podejmujemy decyzje. Przykładowo, w sektorze finansowym algorytmy analizują dane z prędkością nieosiągalną dla człowieka, wspierając trafność decyzji inwestycyjnych.

Jednak automatyzacja to nie tylko korzyści. Niesie ze sobą również poważne wyzwania:

- Ryzyko utraty miejsc pracy w wyniku zastępowania ludzi przez maszyny,

- Problemy z prywatnością i ochroną danych osobowych,

- Nierówny dostęp do technologii, który może pogłębiać społeczne podziały,

- Brak jasności w odpowiedzialności za decyzje podejmowane przez AI – kto ponosi winę, gdy system się myli?

Dlatego potrzebujemy natychmiastowych działań:

- jasnych i spójnych regulacji prawnych,

- otwartego dialogu społecznego,

- wspólnego podejścia do wdrażania AI w życie publiczne.

Przyszłość zależy od nas – od tego, jak świadomie i odpowiedzialnie podejdziemy do tej technologii.

Możliwości i wyzwania związane z rozwojem AI

AI to ogromny potencjał, ale i poważne wyzwania. Z jednej strony umożliwia:

- precyzyjną analizę danych,

- lepsze diagnozy medyczne,

- optymalizację procesów logistycznych,

- automatyzację powtarzalnych zadań.

Z drugiej strony pojawiają się pytania:

- Czy algorytmy są bezpieczne?

- Czy ich działanie jest przejrzyste i zrozumiałe?

- Czy maszyny powinny podejmować decyzje bez udziału człowieka?

Odpowiedzialny rozwój AI to klucz do sukcesu. W praktyce oznacza to:

- testowanie systemów pod kątem uprzedzeń i błędów,

- tworzenie przejrzystych modeli decyzyjnych,

- edukowanie użytkowników w zakresie działania i ograniczeń AI.

To nie są działania na przyszłość – to zadania na dziś. Im szybciej zaczniemy, tym większe szanse na bezpieczne i efektywne wykorzystanie potencjału sztucznej inteligencji.

Kierunki badań i rozwój etycznych systemów AI

Współczesne badania nad AI coraz częściej koncentrują się nie tylko na skuteczności, ale również na aspektach etycznych. Bo co z tego, że system działa szybko, jeśli nie potrafimy zrozumieć, dlaczego podjął konkretną decyzję?

Dlatego rośnie znaczenie tzw. explainable AI – systemów, które potrafią wyjaśnić swoje działania. To podejście:

- buduje zaufanie użytkowników,

- zwiększa poczucie bezpieczeństwa,

- eliminuje efekt “czarnej skrzynki”,

- umożliwia lepszą kontrolę nad technologią.

Równolegle rozwijane są regulacje i standardy – zarówno na poziomie krajowym, jak i międzynarodowym – które mają zapewnić odpowiedzialne wykorzystanie AI. W przyszłości możemy spodziewać się:

- integracji AI z zasadami zrównoważonego rozwoju,

- tworzenia interdyscyplinarnych zespołów projektowych,

- stawiania etyki na równi z technologią,

- większego zaangażowania społecznego w procesy decyzyjne.

To ambitne cele – ale konieczne. Jeśli chcemy, by etyczna AI była standardem, a nie wyjątkiem, musimy działać już teraz.

Może Cię zainteresować:

Historia AI – najważniejsze przełomy, które zmieniły technologię

Co to jest model językowy (np. GPT)? Zasada działania krok po kroku

Czy sztuczna inteligencja zagraża rynkowi pracy? Fakty i mity

Co to jest AGI (Artificial General Intelligence) i kiedy może powstać?

Trendy AI w 2025 roku: Kluczowe kierunki rozwoju sztucznej inteligencji

Sztuczna inteligencja w medycynie – czy diagnozuje lepiej niż lekarz?

Czym jest ChatGPT i jak działa? Jak korzystać z ChatGPT?

Czym jest Gemini AI od Google i jak działa?

Dziękujemy, że przeczytałaś/eś nasz artykuł do końca.

Śledź techoteka.pl i bądź na bieżąco z nowinkami technologicznymi! Obserwuj nas na Facebooku.