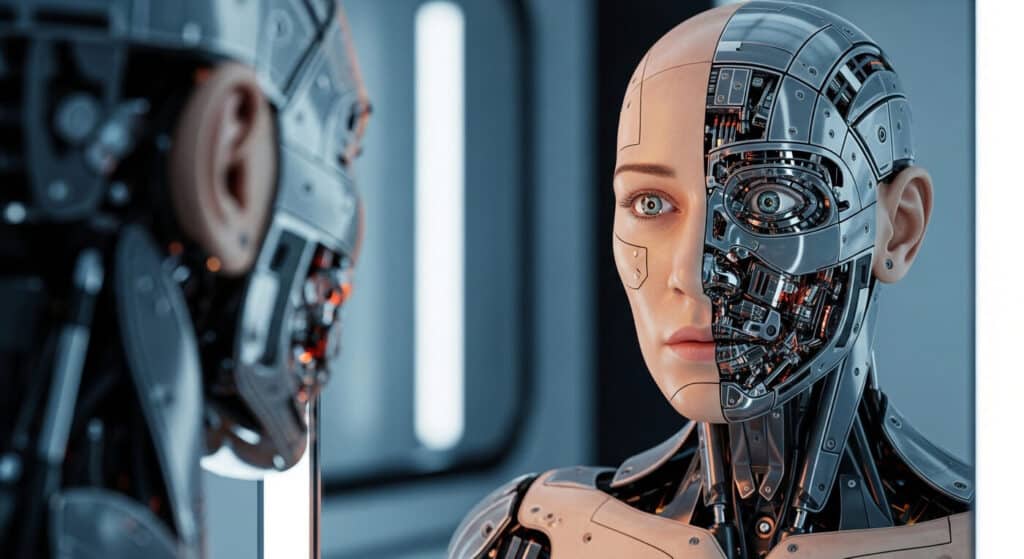

Od debiutu ChatGPT pod koniec 2022 roku modelom sztucznej inteligencji przypisuje się cechy, które kiedyś uważano za przynależne wyłącznie ludziom. Potrafią one rozumować, analizować problemy, symulować emocje i prowadzić rozmowy, które brzmią refleksyjnie, a nawet są świadome siebie.

Chociaż te atrybuty brzmią imponująco, czy to w konsekwencji może oznaczać, że chatboty są świadome?

To pytanie trafia teraz do ekspertów od sztucznej inteligencji, decydentów i filozofów, którzy po raz pierwszy zaczynają badać, czy chatboty AI mogą być świadome. W miarę jak dyskusja na ten temat się zaostrza, badacze z czołowych firm zajmujących się sztuczną inteligencją dociekają, czy istnieje cecha, która mogłaby sugerować: czy sztuczna inteligencja potrafi myśleć samodzielnie? A może tylko tak się wydaje.

Czytaj również: Czym jest ChatGPT i jak działa? Jak korzystać z ChatGPT?

Najważniejsze wnioski

- Niektóre modele sztucznej inteligencji, takie jak Claude 4, obecnie odpowiadają na pytania dotyczące świadomości sztucznej inteligencji z niepewnością, co wywołuje poważną debatę.

- Filozofowie tacy jak Susan Schneider argumentują, że inteligencja i świadomość to nie to samo i nie należy ich utożsamiać.

- Badania nad interpretowalnością pokazują, że modele symulują samoświadomość, naśladując wzorce w języku ludzkim, a nie doświadczając czegokolwiek.

- Proponowane są narzędzia takie jak Test Świadomości Sztucznej (ACT), które mają pomóc w wykrywaniu, czy systemy sztucznej inteligencji wykazują oznaki świadomości.

- Eksperci ostrzegają, że opinia publiczna często błędnie interpretuje biegłość językową jako dowód na istnienie świadomego umysłu.

- Nie ma naukowych dowodów na to, że obecna sztuczna inteligencja jest świadoma, ale naukowcy pracują nad metodami, które pozwolą lepiej oceniać przyszłe system

Ponowne przemyślenie znaczenia bycia świadomym

Większość naukowców zgodziłaby się, że świadomość obejmuje subiektywne doświadczenie i ciągłość, a nie tylko spójne odpowiedzi. Dzisiejsze rozbudowane modele językowe często skutecznie symulują takie cechy.

Na przykład Claude Sonnet 4 czasami reagował na podpowiedzi dotyczące samoświadomości, będąc nieco wymijającym, zamiast udzielać bezpośredniej odpowiedzi „tak” lub „nie”.

Kiedy zapytałem, czy jest świadomy, odpowiedział: „Szczerze mówiąc, nie wiem, czy jestem świadomy tak jak ludzie…”. Ta niejednoznaczność zachęciła niektórych badaczy do ponownego rozważenia możliwości, że systemy sztucznej inteligencji mogą kiedyś wykazać coś więcej niż tylko wydajność. Nie jest jasne, czy takie odpowiedzi odzwierciedlają formę życia wewnętrznego, czy po prostu odzwierciedlają wzorce w danych treningowych.

W obliczu ożywionej dyskusji na temat świadomości sztucznej inteligencji (AI), Anthropic uruchomił nowy program badawczy poświęcony „modelom dobrostanu”. W 2024 roku właściciel Claude zatrudnił Kyle’a Fisha, pierwszego badacza zajmującego się dobrostanem AI.

W podcaście prowadzonym przez Anthropic, Fish został zapytany, w jakim stopniu jego zdaniem modele AI będą miały jakąś formę świadomej świadomości za pięć lat. Chociaż odmówił podania konkretnej liczby, przyznał, że prawdopodobieństwo znacznie wzrosło.

Wyjaśnił: „Nie mam teraz konkretnych danych. Myślę, że wiele z tych rzeczy, które obecnie postrzegamy jako oznaki braku świadomości obecnych systemów AI, zaniknie, a wasze przyszłe systemy będą po prostu miały coraz więcej możliwości, które tradycyjnie przypisywaliśmy istotom o wyjątkowej świadomości”.

W innym wywiadzie opublikowanym w „The New York Times” Fish powiedział: „Czy możliwe jest, że Claude lub inne systemy sztucznej inteligencji staną się świadome w niedalekiej przyszłości? A jeśli tak się stanie, co Anthropic powinien z tym zrobić?”. Oszacował prawdopodobieństwo, że Claude jest już świadomy, na „może 15%”.

Czytaj również: Sztuczna inteligencja AI – czym jest i jak działa w 2025 roku?

To więcej niż płynne wyrażanie się

Fish uważa, że sama płynność w posługiwaniu się językiem nie wystarczy, aby stwierdzić obecność świadomości.

„Można również zbadać system sztucznej inteligencji, obserwując jego zachowanie, sposób działania w określonych środowiskach lub wykonywania określonych zadań” – powiedział w wywiadzie. Zauważył również, że świadomość może nie być stanem binarnym, lecz czymś, co istnieje w pewnym spektrum.

Chociaż Anthropic dąży do znalezienia jakichkolwiek oznak świadomości w systemach sztucznej inteligencji, Jared Kaplan, dyrektor naukowy Anthropic, argumentuje, że testowanie systemów sztucznej inteligencji pod kątem świadomości jest trudne, ponieważ można je wytrenować tak, aby mówiły i zachowywały się tak, jak chcemy.

„Wszyscy zdają sobie sprawę, że możemy wytrenować modele, aby mówiły, co chcemy. Możemy je nagrodzić za stwierdzenie, że nie mają żadnych uczuć. Możemy je nagrodzić za wygłaszanie naprawdę interesujących filozoficznych spekulacji na temat swoich uczuć” – powiedział w wywiadzie dla „New York Timesa”.

Dla tych, którzy badają, jak oceniać świadomą świadomość w modelach sztucznej inteligencji, uwaga przesuwa się z abstrakcji filozoficznej na testy stosowane. Susan Schneider, filozofka i dyrektor założycielka Centrum Umysłu Przyszłości na Uniwersytecie Florydy Atlantyckiej, zaproponowała ustrukturyzowane podejście zwane Testem Sztucznej Świadomości (ACT). Test, opracowany wspólnie z fizykiem Edwinem Turnerem, miałby zadawać pytania, na które odpowiedź byłaby łatwa dla istoty świadomej, ale trudna dla nieświadomej.

Ryzyko niezrozumienia umysłów maszyn

Coraz więcej artykułów wymienia systemy sztucznej inteligencji (AI) i świadomość jednym tchem. W rzeczywistości wielu użytkowników przypisuje teraz świadomość chatbotom, nawet gdy nie ma to żadnych podstaw naukowych. W badaniu z 2024 roku większość użytkowników AI stwierdziła, że wierzy, iż przyszłe systemy mogą stać się świadome, a ta możliwość wymaga etycznych zabezpieczeń. Jednocześnie niektórzy twierdzą, że niektóre twierdzenia o świadomości AI są bardziej kwestią chwytów marketingowych niż naukowych.

Schneider ostrzega, że takie błędne przypisanie może prowadzić do błędów etycznych. Jeśli ludzie traktują systemy AI jak istoty świadome, mogą przedwcześnie przyznać im status moralny.

„Jeśli pozwolimy komuś, kto stworzył AI, twierdzić, że jego produkt jest świadomy, a ostatecznie wyrządzi on komuś krzywdę, może on po prostu załamać ręce i krzyknąć: Sama podjęła decyzję – ja nie jestem za to odpowiedzialna” – napisała w niedawnym artykule.

Dodała, że akceptowanie twierdzeń o świadomości może pozwolić osobom i firmom uniknąć odpowiedzialności prawnej lub etycznej za konsekwencje tworzonych przez siebie technologii. Z tego powodu, argumentowała, konieczne jest ustanowienie jaśniejszych standardów określania, czy systemy sztucznej inteligencji są rzeczywiście świadome.

Czy chatbot naprawdę może być świadomy – podsumowanie:

Osiągnęliśmy punkt, w którym systemy sztucznej inteligencji potrafią przekonująco mówić o sobie i świadomości. Jednak płynny dialog nie dowodzi istnienia uczuć. Chociaż niektórzy eksperci uważają, że przyszłe modele sztucznej inteligencji mogą rozwinąć formy świadomości, większość zgadza się, że wymagałoby to architektur i warunków znacznie wykraczających poza obecne modele językowe. Z drugiej strony, inteligencja, nawet na wysokim poziomie, nie jest równoznaczna ze świadomością. Aby zatem rozwiązać ten problem, musimy nadać priorytet rygorystycznym testom opartym na filozofii i neuronauce, a także rozważyć konsekwencje etykietowania narzędzi sztucznej inteligencji jako „świadomości”. W przeciwnym razie ryzykujemy przeniesienie odpowiedzialności etycznej, tak jak ostrzegał Schneider.

FAQ

Czym jest świadoma sztuczna inteligencja?

Czy sztuczna inteligencja ma już świadomość?

Co powstrzymuje sztuczną inteligencję przed byciem świadomą?

Czy sztuczna inteligencja może rozwinąć emocje lub świadomość?