NPU w procesorach to jedno z najważniejszych pojęć współczesnej technologii, które wciąż jest zaskakująco słabo rozumiane – nawet wśród osób interesujących się sprzętem komputerowym. Jeszcze kilka lat temu cały świat IT opierał się na prostym duecie: CPU i GPU. Dziś ten układ przestaje wystarczać. Powodem jest sztuczna inteligencja, a dokładniej jej masowe wejście do codziennych urządzeń. To właśnie tutaj NPU w procesorach odgrywa kluczową rolę.

Ten artykuł to kompleksowe i eksperckie opracowanie tematu NPU w procesorach, przygotowane z myślą o osobach, które chcą naprawdę zrozumieć, jak działa sztuczna inteligencja na poziomie sprzętowym. Tekst w przystępny, ale dogłębny sposób wyjaśnia, czym jest NPU w procesorach, jak funkcjonuje w praktyce oraz czym różni się od CPU i GPU. Bez uproszczeń i marketingowych sloganów pokazujemy, dlaczego to właśnie NPU w procesorach staje się kluczowym elementem nowoczesnej architektury sprzętu – od komputerów i smartfonów po samochody i zaawansowane systemy AI.

Definicja NPU (Neural Processing Unit)

NPU (Neural Processing Unit) to specjalistyczny procesor zaprojektowany do efektywnego wykonywania zadań związanych ze sztuczną inteligencją (AI) oraz uczeniem maszynowym. W przeciwieństwie do CPU i GPU, NPU zostało zoptymalizowane pod konkretne operacje wykorzystywane w sieciach neuronowych, takie jak obliczenia macierzowe, tensorowe oraz inferencja modeli AI.

NPU w procesorach umożliwia lokalne przetwarzanie danych przez algorytmy sztucznej inteligencji, oferując wysoką wydajność przy bardzo niskim zużyciu energii. Dzięki temu funkcje AI mogą działać w czasie rzeczywistym bez konieczności korzystania z chmury, co przekłada się na większą prywatność, krótsze opóźnienia oraz lepszą energooszczędność urządzeń takich jak smartfony, laptopy, komputery osobiste czy systemy wbudowane.

NPU w procesorach jako odpowiedź na erę sztucznej inteligencji

Jeszcze do niedawna sztuczna inteligencja kojarzyła się głównie z centrami danych, serwerowniami i potężnymi kartami graficznymi. AI była czymś „odległym”, działającym w chmurze. Użytkownik końcowy widział jedynie efekt końcowy: rozpoznane zdjęcie, przetłumaczony tekst, sugestię algorytmu. Obliczenia odbywały się gdzieś daleko, poza urządzeniem.

Dziś ten model przestaje być wystarczający. Coraz więcej funkcji AI musi działać lokalnie, w czasie rzeczywistym, bez opóźnień i bez wysyłania danych do chmury. Właśnie w tym miejscu na scenę wchodzi NPU w procesorach.

NPU w procesorach to wyspecjalizowany blok obliczeniowy zaprojektowany wyłącznie do jednego celu: jak najszybszego i jak najbardziej energooszczędnego wykonywania obliczeń związanych ze sztuczną inteligencją. Nie jest to „kolejny rdzeń CPU” ani „okrojone GPU”. To zupełnie inna filozofia projektowania układów scalonych.

Może Cię zainteresować: Wojna technologiczna USA–Chiny: jak półprzewodniki stały się bronią geopolityczną

NPU w procesorach – co oznacza ten skrót i dlaczego jest mylący

Skrót NPU pochodzi od „Neural Processing Unit”, czyli jednostki przetwarzania neuronowego. Już sama nazwa sugeruje, że NPU w procesorach zostało zaprojektowane z myślą o sieciach neuronowych i algorytmach uczenia maszynowego.

Problem polega na tym, że wiele osób błędnie zakłada, iż NPU w procesorach to po prostu „akcelerator AI” podobny do GPU. W rzeczywistości różnice są znacznie głębsze i dotyczą samej struktury obliczeń, sposobu pracy z pamięcią oraz zarządzania energią.

NPU w procesorach nie jest uniwersalne. Nie uruchomisz na nim systemu operacyjnego. Nie obsłuży klasycznych aplikacji. Jego zadaniem nie jest elastyczność, lecz maksymalna wydajność w bardzo wąskim zakresie zastosowań. To właśnie ta specjalizacja sprawia, że NPU w procesorach jest tak skuteczne.

CPU a NPU w procesorach – fundamentalna różnica filozofii

Aby dobrze zrozumieć, czym jest NPU w procesorach, trzeba zacząć od CPU, czyli klasycznego procesora centralnego. CPU został zaprojektowany jako jednostka ogólnego przeznaczenia. Jego zadaniem jest wykonywanie bardzo różnorodnych instrukcji: od prostych operacji matematycznych, przez logikę systemową, aż po zarządzanie pamięcią i urządzeniami wejścia-wyjścia.

CPU świetnie radzi sobie z zadaniami sekwencyjnymi, podejmowaniem decyzji i obsługą złożonych struktur logicznych. Jednak w przypadku sztucznej inteligencji CPU natrafia na naturalne ograniczenia. Modele AI opierają się na ogromnej liczbie powtarzalnych operacji matematycznych, głównie na macierzach i tensorach. Dla CPU są to zadania ciężkie, energochłonne i mało efektywne.

NPU w procesorach powstało właśnie po to, aby zdjąć z CPU ten ciężar. Zamiast uniwersalnych rdzeni mamy wyspecjalizowane jednostki, które wykonują dokładnie te operacje, jakich potrzebuje AI – i nic więcej. Dzięki temu NPU w procesorach osiąga wydajność nieosiągalną dla CPU przy tym samym zużyciu energii.

GPU a NPU w procesorach – podobieństwa, które prowadzą do błędnych wniosków

Na pierwszy rzut oka GPU i NPU w procesorach mogą wydawać się podobne. Oba układy są zoptymalizowane pod obliczenia równoległe. Oba świetnie radzą sobie z macierzami i dużymi zbiorami danych. To właśnie dlatego GPU przez wiele lat było podstawowym narzędziem do trenowania modeli AI.

Różnica polega jednak na kontekście użycia. GPU to jednostka zaprojektowana z myślą o ogromnej mocy obliczeniowej, bez większego nacisku na oszczędność energii. Doskonale sprawdza się w centrach danych, stacjach roboczych i komputerach gamingowych. W świecie mobilnym i w laptopach GPU szybko ujawnia swoje wady: wysokie zużycie energii, generowanie ciepła i konieczność aktywnego chłodzenia.

NPU w procesorach działa zupełnie inaczej. Jego celem nie jest maksymalna moc, lecz maksymalna efektywność. To właśnie dlatego NPU w procesorach idealnie nadaje się do zadań takich jak rozpoznawanie mowy, analiza obrazu, przetwarzanie wideo czy działanie lokalnych modeli językowych – wszystko to bez drastycznego wpływu na baterię.

NPU w procesorach i obliczenia tensorowe – sedno działania AI

Sercem działania sztucznej inteligencji są obliczenia tensorowe. To właśnie one decydują o tym, jak szybko model AI potrafi rozpoznać obraz, przetworzyć tekst czy wygenerować odpowiedź. NPU w procesorach zostało zaprojektowane od podstaw z myślą o takich operacjach.

W przeciwieństwie do CPU, które wykonuje instrukcje sekwencyjnie, NPU w procesorach przetwarza ogromne ilości danych jednocześnie. Co więcej, robi to z użyciem obniżonej precyzji obliczeń. Dla algorytmów AI dokładność rzędu kilku miejsc po przecinku jest często zupełnie wystarczająca. Dzięki temu NPU w procesorach może wykonywać obliczenia szybciej i przy znacznie mniejszym zużyciu energii.

To właśnie ten kompromis między precyzją a wydajnością sprawia, że NPU w procesorach jest tak skuteczne w zastosowaniach AI.

NPU w procesorach a zużycie energii – kluczowy argument przemysłu

Jednym z najważniejszych powodów, dla których NPU w procesorach zyskuje na znaczeniu, jest efektywność energetyczna. W świecie mobilnym i laptopowym energia jest zasobem krytycznym. Każdy dodatkowy wat oznacza krótszy czas pracy na baterii i większe problemy z temperaturą.

CPU i GPU, choć potężne, nie zostały zaprojektowane z myślą o ciągłej pracy algorytmów AI. NPU w procesorach może działać w tle niemal non stop, zużywając minimalne ilości energii. To właśnie dlatego funkcje AI w nowoczesnych urządzeniach są „zawsze aktywne” i nie wpływają drastycznie na czas pracy baterii.

NPU w procesorach w laptopach i komputerach osobistych

Jeszcze kilka lat temu komputery osobiste nie potrzebowały dedykowanych jednostek AI. Dziś sytuacja zmienia się bardzo szybko. Systemy operacyjne, aplikacje biurowe, narzędzia kreatywne i komunikatory coraz częściej wykorzystują algorytmy uczenia maszynowego.

NPU w procesorach umożliwia lokalne przetwarzanie AI bez konieczności korzystania z chmury. Oznacza to nie tylko większą prywatność, ale również natychmiastową reakcję systemu. Funkcje takie jak inteligentne kadrowanie obrazu, redukcja szumów, rozpoznawanie mowy czy lokalne modele językowe stają się możliwe właśnie dzięki NPU w procesorach.

NPU w procesorach w smartfonach – cichy bohater mobilnej rewolucji

Smartfony były jednym z pierwszych urządzeń, w których NPU w procesorach zaczęło odgrywać kluczową rolę. To właśnie dzięki NPU możliwe stało się wykonywanie zdjęć nocnych w czasie rzeczywistym, rozpoznawanie twarzy czy zaawansowane przetwarzanie obrazu bez zauważalnych opóźnień.

W smartfonach NPU w procesorach musi spełniać szczególnie rygorystyczne wymagania dotyczące zużycia energii i temperatury. To właśnie tutaj najlepiej widać przewagę NPU nad CPU i GPU. Algorytmy AI mogą działać cały czas, a użytkownik nie odczuwa spadku wydajności ani skrócenia czasu pracy baterii.

NPU w procesorach a prywatność danych

W dobie rosnących obaw o prywatność danych NPU w procesorach nabiera dodatkowego znaczenia. Przetwarzanie danych lokalnie oznacza, że informacje nie muszą opuszczać urządzenia. Zdjęcia, nagrania głosu czy dane biometryczne mogą być analizowane bezpośrednio na sprzęcie użytkownika.

Dzięki NPU w procesorach możliwe jest tworzenie rozwiązań AI, które są jednocześnie zaawansowane i bezpieczne. To szczególnie istotne w kontekście zastosowań biznesowych, medycznych i administracyjnych.

NPU w procesorach w motoryzacji i systemach wbudowanych

Samochody autonomiczne, systemy wspomagania kierowcy, monitoring wizyjny czy inteligentne fabryki – wszystkie te obszary intensywnie wykorzystują sztuczną inteligencję. W takich zastosowaniach NPU w procesorach jest absolutnie kluczowe.

AI musi działać w czasie rzeczywistym, bez opóźnień i przy minimalnym zużyciu energii. NPU w procesorach spełnia te wymagania znacznie lepiej niż CPU czy GPU, dlatego staje się standardem w systemach wbudowanych.

NPU w procesorach jako przyszłość architektury komputerowej

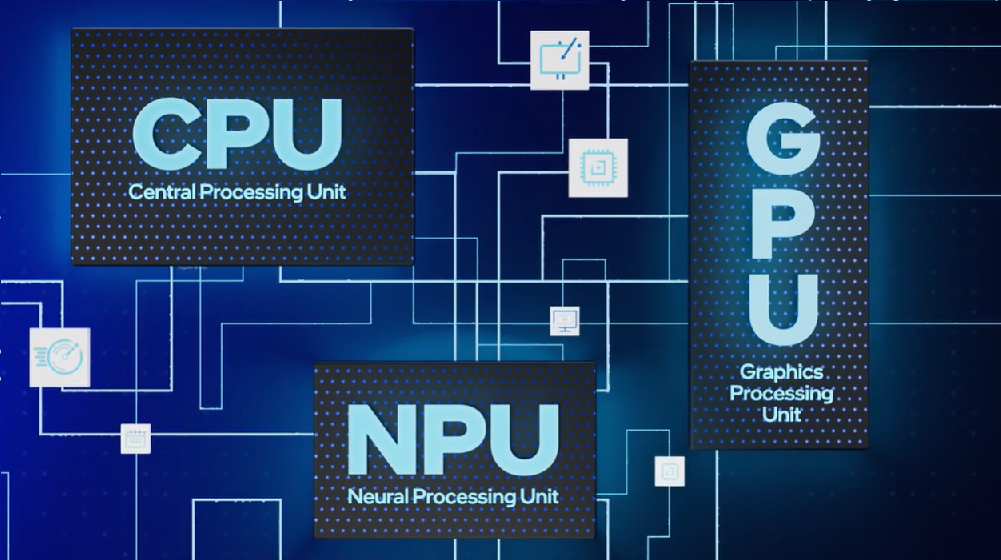

Wszystko wskazuje na to, że przyszłość architektury komputerowej będzie oparta na trójpodziale ról: CPU jako jednostka sterująca, GPU jako silnik grafiki i obliczeń równoległych oraz NPU w procesorach jako wyspecjalizowany silnik sztucznej inteligencji.

Ten model pozwala na maksymalną efektywność, lepsze zarządzanie energią i znacznie większe możliwości rozwoju AI na urządzeniach końcowych.

Może Cię zainteresować: RISC-V – architektura, która może wywrócić rynek CPU

NPU w procesorach – podsumowanie eksperckie

NPU w procesorach to nie chwilowa moda ani marketingowy dodatek. To fundamentalna zmiana w sposobie projektowania układów scalonych. Dzięki NPU możliwe staje się przeniesienie sztucznej inteligencji z chmury bezpośrednio do urządzeń użytkowników.

Różnice między NPU w procesorach, CPU i GPU nie sprowadzają się wyłącznie do wydajności. To różnice w filozofii działania, efektywności energetycznej, bezpieczeństwie i możliwościach skalowania AI.

Na techoteka.pl temat NPU w procesorach będzie wracał wielokrotnie, bo to właśnie ta technologia w największym stopniu wpłynie na przyszłość komputerów, smartfonów i całej branży technologicznej.

FAQ – NPU w procesorach

Czym jest NPU w procesorach i do czego służy?

Dlaczego NPU w procesorach jest coraz ważniejsze niż CPU?

Czym różni się NPU w procesorach od GPU?

Czy NPU w procesorach zastąpi GPU w zadaniach AI?

Jakie zastosowania ma NPU w procesorach w codziennym użytkowaniu?

Czy NPU w procesorach działa tylko z AI?

Czy każdy nowoczesny procesor ma NPU?

Jak NPU w procesorach wpływa na czas pracy baterii?

Czy NPU w procesorach poprawia prywatność użytkownika?

Jaką rolę będzie odgrywać NPU w procesorach w przyszłości?

Dziękujemy, że przeczytałaś/eś nasz artykuł do końca.

Śledź techoteka.pl i bądź na bieżąco z nowinkami technologicznymi! Obserwuj nas na Facebooku.