Sztuczna inteligencja miała ułatwiać życie, zwiększać produktywność i chronić użytkowników przed zagrożeniami cyfrowymi. I w wielu obszarach faktycznie to robi. Problem polega na tym, że dokładnie te same technologie trafiają dziś w ręce cyberprzestępców – a tam ich potencjał rośnie w zastraszającym tempie.

W 2026 roku cyberprzestępczość przestaje być chaotyczna i „ręczna”. Ataki są zautomatyzowane, spersonalizowane i skalowane przez AI. Co gorsza, wiele z tych zagrożeń nie trafia jeszcze do mainstreamowych raportów, bo są zbyt nowe, zbyt trudne do wykrycia albo… zbyt niewygodne.

Ten artykuł to raport Techoteki o ciemnej stronie AI:

-

jak cyberprzestępcy wykorzystują AI tu i teraz,

-

jakie nowe typy ataków się pojawiły,

-

dlaczego tradycyjne zabezpieczenia przestają wystarczać,

-

i co mogą zrobić użytkownicy oraz firmy, zanim będzie za późno.

AI jako „force multiplier” cyberprzestępczości

Sztuczna inteligencja nie tworzy nowych intencji przestępczych.

Ale dramatycznie zwiększa skalę, skuteczność i tempo ataków.

To, co kiedyś wymagało:

-

zespołu ludzi,

-

tygodni przygotowań,

-

ręcznej analizy ofiar,

dziś może zostać wykonane:

-

automatycznie,

-

w kilka minut,

-

na tysiącach celów jednocześnie.

Cyberprzestępcy używają AI jako force multiplier – wzmacniacza siły.

Dlaczego o wielu zagrożeniach AI się nie mówi?

1. Bo są „zbyt techniczne” dla mediów

2. Bo uderzają w zaufanie do technologii

3. Bo często dotyczą firm i instytucji, które nie chcą się przyznać

4. Bo nie wyglądają spektakularnie – aż do momentu szkody

Efekt?

Użytkownicy dowiadują się za późno.

Nowa generacja phishingu: AI-phishing 2.0

Jak działa AI-phishing w 2026:

-

AI analizuje social media ofiary,

-

dopasowuje język, ton i styl,

-

uwzględnia aktualne wydarzenia,

-

generuje idealnie spersonalizowane wiadomości.

To już nie phishing masowy.

To spear phishing w skali przemysłowej.

Dlaczego to działa?

Bo wiadomość brzmi dokładnie tak, jakby napisał ją:

-

szef,

-

księgowa,

-

partner biznesowy,

-

znajomy.

Deepfake audio i wideo jako narzędzie oszustwa

Cyberprzestępcy łączą AI-phishing z:

-

klonowaniem głosu,

-

deepfake wideo,

-

fałszywymi wideokonferencjami.

Wystarczy:

-

kilka nagrań z YouTube,

-

fragmenty wystąpień publicznych,

-

posty w social mediach.

Efekt?

Fałszywy telefon od „prezesa”, który brzmi idealnie.

Fałszywy call na Teamsach, gdzie „wszystko się zgadza”.

To już się dzieje – także w Europie.

Może Cię zainteresować: Deepfake 2026 – jak odróżnić prawdę od fałszu w sieci

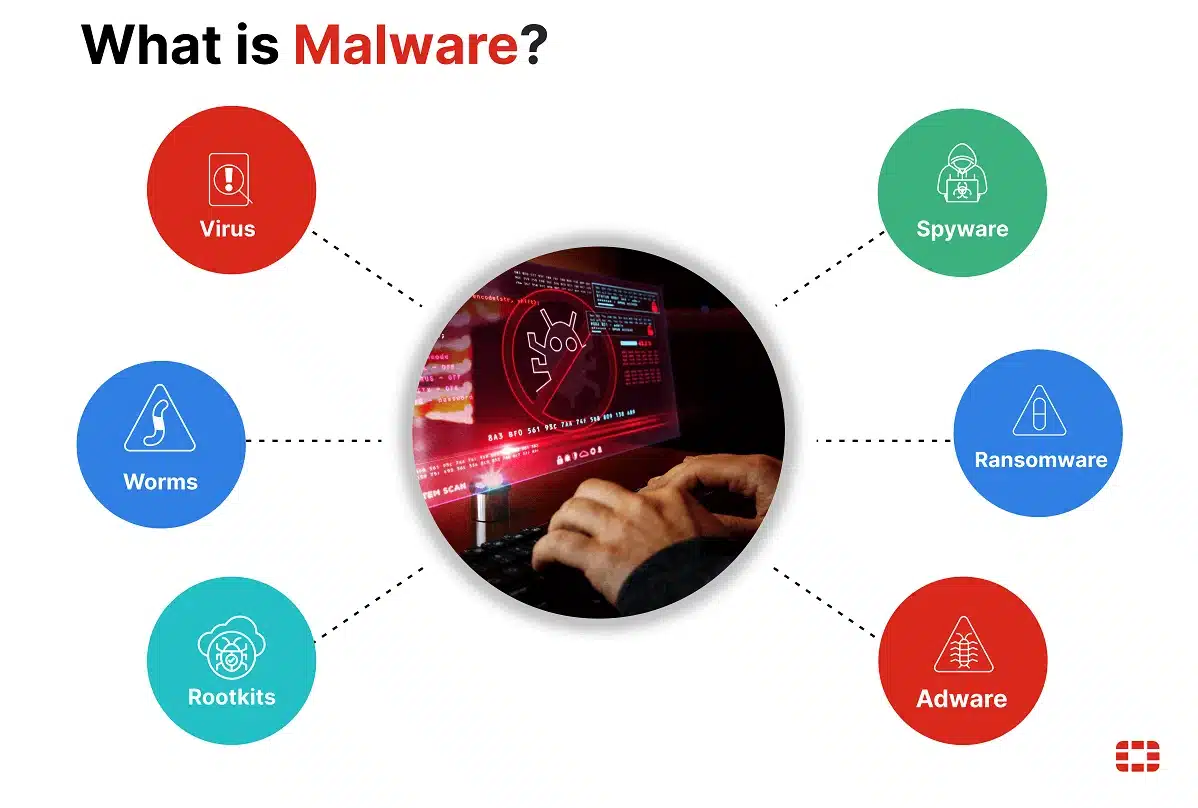

AI w malware: złośliwe oprogramowanie, które się uczy

Tradycyjne malware:

-

miało stały kod,

-

dało się wykryć sygnaturami,

-

zachowywało się przewidywalnie.

Malware wspierane przez AI:

-

zmienia zachowanie w czasie rzeczywistym,

-

uczy się systemu ofiary,

-

omija klasyczne zabezpieczenia,

-

wybiera najlepszy moment ataku.

To adaptacyjne zagrożenie, a nie „wirus”.

AI a ataki na hasła i tożsamość

AI drastycznie przyspieszyła:

-

łamanie haseł,

-

ataki typu credential stuffing,

-

przejmowanie kont.

Modele językowe:

-

generują realistyczne hasła,

-

przewidują schematy użytkowników,

-

analizują wycieki danych.

Efekt:

Hasło „silne” w 2020 roku w 2026 jest śmiesznie słabe.

Dark web + AI = cyberprzestępczość jako usługa

Na forach dark web:

-

AI-boty do phishingu są sprzedawane jak SaaS,

-

dostępne są „pakiety ataków”,

-

cyberprzestępczość się demokratyzuje.

Nie trzeba być hakerem.

Wystarczy abonament.

Może Cię zainteresować: Darknet vs Deep Web 2025: Co to jest i czym się różnią?

Ataki na firmy: cichy sabotaż zamiast głośnych ransomware

Ransomware nadal istnieje.

Ale coraz częściej celem jest:

-

cicha manipulacja danymi,

-

zmiana wyników,

-

sabotaż decyzji.

AI pozwala:

-

modyfikować dane stopniowo,

-

unikać wykrycia,

-

wywoływać błędne decyzje biznesowe.

To najgroźniejszy typ ataku, bo trudny do zauważenia.

AI kontra AI – nowy wyścig zbrojeń

Firmy odpowiadają:

-

AI do wykrywania anomalii,

-

systemy behawioralne,

-

analizy w czasie rzeczywistym.

Ale to wyścig, nie rozwiązanie raz na zawsze.

Cyberprzestępcy:

-

testują swoje ataki na AI,

-

uczą się omijać zabezpieczenia,

-

adaptują się szybciej niż procedury korporacyjne.

O czym naprawdę się nie mówi?

1. AI obniża próg wejścia w cyberprzestępczość

2. Użytkownicy są najsłabszym ogniwem

3. Prawo nie nadąża

4. Edukacja jest dramatycznie opóźniona

Największym zagrożeniem nie jest sama AI, tylko:

brak świadomości, że zmieniły się zasady gry.

Jak chronić się przed AI-wspieranymi atakami?

Dla użytkowników:

-

zero zaufania do „pilnych” próśb,

-

weryfikacja drugim kanałem,

-

menedżery haseł + MFA,

-

ograniczenie danych publicznych.

Dla firm:

-

procedury, nie tylko narzędzia,

-

szkolenia z AI-zagrożeń,

-

zasada „zero trust”,

-

testy socjotechniczne.

Przyszłość cyberprzestępczości z AI

W 2026 roku:

-

ataki będą rzadsze, ale bardziej precyzyjne,

-

straty będą większe,

-

ofiary często nie zorientują się od razu.

Cyberbezpieczeństwo przestaje być IT-problemem.

To problem strategiczny.

Podsumowanie: AI to narzędzie – także dla przestępców

AI sama w sobie nie jest zła.

Ale w rękach cyberprzestępców staje się idealnym narzędziem do oszustwa, manipulacji i sabotażu.

Wygrywają ci, którzy:

-

rozumieją zagrożenia,

-

reagują wcześniej,

-

inwestują w wiedzę, nie tylko w software.

Reszta… dowie się o problemie po fakcie.

Dziękujemy, że przeczytałaś/eś nasz artykuł do końca.

Śledź techoteka.pl i bądź na bieżąco z nowinkami technologicznymi! Obserwuj nas na Facebooku.